محاسبات با کارایی بالا

نسل بعدی پردازش دادهها در مقیاسهای غیرقابل تصور اتفاق خواهد افتاد و به ما اجازه خواهد داد بزرگترین و پیچیدهترین مشکلات را مدلسازی و حل کنیم. امروزه، همه جا صحبت از پردازش و انتقال سریع اطلاعات است که ماهیتی ترکیبی بوده و برخواسته از پردازش، شبکهسازی و ذخیرهسازی است. محاسبات با کارایی بالا، این ایده را تقویت میکند و توان محاسباتی را به شکل تجمیعشده در اختیار ما قرار میدهد. واقعیت این است که حل برخی از مشکلات محاسباتی بزرگ به توان محاسباتی سنگینی نیاز دارد. معماری محاسبات با کارایی بالا قادر است سیستمهای محاسباتی مختلف را به هم متصل میکند تا شبیه به یک گروه کار کنند و پاسخها را در زمان کوتاهتری ارائه دهند. با توانایی انجام محاسبات بسیار سریع، رایانش ابری و هوش مصنوعی شرایط را برای پذیرش گسترده محاسبات با عملکرد بالا هموار کردهاند تا دستیابی به نتایج غیرممکن را ممکن کنند.

الئونور واتسون، عضو IEEE، مهندس اخلاق هوش مصنوعی و استاد هوش مصنوعی دانشگاه سینگ ularity میگوید: «به طور معمول، محاسبات با کارایی بالا مبتنی بر کامپیوترهای بزرگ هستند، اما گاهی اوقات از کامپیوترهای بازی قدیمی یا حتی کامپیوترهای خانگی نیز میتوان برای تعریف این محیطها استفاده کرد.».

محاسبات با عملکرد بالا از طریق تقسیم یک مسئله بزرگ به قسمتهای کوچکتر و توزیع آن میان کامپیوترهای مختلف کار میکنند. هر کامپیوتر بخشی از مسئله را حل میکند و در نهایت همه جوابها با هم ترکیب میشوند و به عنوان راهحل نهایی در اختیار ما قرار میگیرند. این معماری تحت عنوان محاسبات موازی (Parallel Computing) نامیده میشوند.

با اینحال، محاسبات با عملکرد بالا تنها بر مبنای توان پردازندههای مرکزی تعریف نمیشوند. پیادهسازی کانالها و شبکههای سریع اهمیت زیادی دارند و اجازه میدهند اطلاعات با سرعت بالایی ارسال و دریافت شوند. با توجه به اینکه مبحث کلان دادهها اهمیت زیادی دارد و در قالب مجموعه دادههای مختلفی در دسترس ما قرار دارند، بنابراین به حافظه و فضای ذخیرهسازی خیلی زیادی برای میزبانی آنها نیاز داریم.

محاسبات با کارایی بالا چه کاربردهایی دارند؟

تصور کنید میخواهید جمعیت دنیا را با کاغذ و قلم بشمارید. شما نمیتوانید به سرعت تغییرات جمعیت را بنویسید، چه برسد به اینکه نتیجهگیری نیز انجام دهید. تنها راه برای محاسبه چنین اطلاعات بزرگی ساخت یک مدل کامپیوتری است. برخی از این مدلها بیش از اندازه بزرگ هستند، به طوری که کامپیوترهای قدرتمند نیز توانایی پردازش آنها را دارند. در چنین شرایطی است که محاسبات با عملکرد بالا به یاری ما میآیند. الئونور واتسون میگوید: «رایانههای پرقدرت به دانشمندان کمک میکنند تا مشکلات پیچیدهای را حل کنند که با کامپیوترهای معمولی نمیشود آنها را حل کرد.»

مشکلات پیچیده نیاز به بررسی و آزمایش دارند تا بفهمیم چه چیزی مهم است و چه تاثیری دارد. حدس زدن کافی نیست و متاسفانه کامپیوترهای عادی نمیتوانند مثل زیرساختهای مبتنی بر محاسبات با عملکرد بالا سریع و دقیق کار کنند. این در حالی است که آمارها و گزارشها به این نکته اشاره دارند که به کارگیری معماری محاسبات با عملکرد بالا در شرکتها، باعث پیشرفت، سرعت و سوددهی بیشتر شده است. به طوری که در زمینههایی مثل هوافضا، خودرو، دارو و شهرسازی نقش تعیینکنندهای دارند. به طور مثال، محاسبات با عملکرد بالا در یافتن واکسن کرونا نقش تعیینکنندهای داشتند. این زیرساخت قدرتمند به دانشمندان و پزشکان در پیشبینی شیوع بیماریها، بررسی ساختار ویروسها و ساخت واکسن کمک زیادی کرد. به طور مثال، زیرساخت قدرتمند Summit توانست با بررسی میلیاردها مدل ویروسی، داروهای موثر را پیدا کند، اما کرونا تنها استفاده پزشکی HPC نیست. ذخیره اطلاعات ژنتیکی افراد به یافتن بیماریهای ژنتیکی کمک میکند تا دانشمندان بتوانند داروهای مخصوص برای هر فرد بسازند. گوگل از HPC برای پیشبینی ساختار پروتئینها استفاده میکند. فهمیدن شکل پروتئینها به ساخت داروهای بهتر کمک میکند.

مدلسازی دقیق آب و هوا یکی از مهمترین و سختترین مشکلات است. برای پیشبینی بهتر اوضاع جوی، سازمانهای هواشناسی از HPC برای ساخت شبیهسازی استفاده میکنند. علاوه بر پیشبینی اوضواع جوی، HPC میتواند با ساخت توربینهای بادی و پنلهای خورشیدی بهتر به مقابله با تغییرات آب و هوایی کمک کند.

مولفههای اصلی HPC

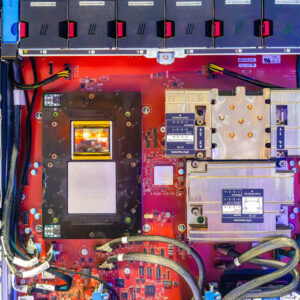

به زبان ساده، HPC عملکردی مشابه کامپیوترهای خانگی دارد، اما در مقیاس بسیار بزرگتر و با قطعاتی که همیشه به صورت فیزیکی به یکدیگر متصل نیستند. بخش اول پردازندههایی هستند که بخشهایی از یک مشکل را میگیرند و محاسبات را به طور همزمان انجام میدهند. در این حالت، کار میان پردازندهها ترکیب میشود و آنها بر مبنای الگوریتمهای مشخصی با یکدیگر ارتباط برقرار میکنند تا سرانجام یک خروجی نهایی را ارائه دهند.

دومین بخش ذخیرهسازی است، جایی که نه تنها کدهای برنامه، بلکه دادههای ورودی باید ذخیرهسازی شوند. هیچ نوار مغناطیسی یا حافظه حالت جامد (SSD) منفردی پهنای باند یا ظرفیت HPC را نخواهد داشت، بنابراین چند رسانه ذخیرهسازی (دیسک و غیره) باید به هم متصل شوند. این حرف بدان معنا است که فناوریهای داخلی دیسکها مثل فریمویرها (مکانیسمهایی که بیتها را ذخیره و بازیابی میکنند) و سایر مولفههای سختافزاری باید به اندازه کافی سریع باشند تا بتوانند یک سیستم مجازی ذخیرهسازی بزرگ را تعریف کنند تا بتواند حجم زیادی از دادههای مورد نیاز HPC را مدیریت کند.

بنابراین، ما نیازمند شبکههایی با پهنای باند و سرعت بالا هستیم که اجازه دهند اطلاعات را سریع به کامپیوترهای هدف برسانیم و نتایج را دریافت کنیم. با توجه به اینکه اطلاعات ماهیت پویایی دارند، شبکه باید خیلی سریع باشد تا اطلاعات جدید را دریافت کند. به بیان دقیقتر، شبکه باید در بالاترین سطح نه تنها باید برای دریافت مجموعه دادههای اولیه، بلکه برای دریافت بهروزرسانیهای مستمر نیز آمادگی کافی را داشته باشد.

مشکلات بزرگ و سیستمهای پیچیده

برنامههایی مثل مدلسازی ویروس کرونا یا بررسی فعالیتهای خورشیدی به کامپیوترهای قدرتمند و فضای ذخیرهسازی زیادی نیاز دارند. این اطلاعات به اندازهای زیاد هستند که نمیتوان همه آنها را در یک کامپیوتر یا دیسک قرار داد. برای حل این مشکل، سیستمهای خاصی ساخته شدهاند تا همه چیز را مدیریت کنند. این سیستمها با توجه به نیاز به برق، شبکه، فضای ذخیرهسازی و سرعت اطلاعات، به گونهای برنامهریزی و مستقر میشوند تا دادهها را به نقاط مختلف و صحیح ارسال کنند و از منابع به بهترین شکل استفاده کنند. خوشبختانه، پیشرفت در حوزه شبکههای کامپیوتری باعث شده تا مولفههای مختلف را در مکانهای متنوع مستقر کرد. یک مثال خوب، پروژه AIRR سرنام AI Research Resource است که برای توسعه محاسبات با عملکرد بالا در زمینه تحقیقات هوش مصنوعی توسط موسسه تحقیقات و نوآوری انگلستان در حال انجام است. سیستمهای HPC معمولا از چند کامپیوتر تشکیل شدهاند که به هم وصل هستند. به طور مثال، سیستم Dawn در کمبریج بیش از هزار پردازنده قوی دارد و همچنین، در نمونه دیگری، سیستم Isambard-AI در بریستول بیش از پنج هزار پردازنده دارد.

شرکتهای بزرگ فعال در زمینه HPC

بازار جهانی رایانههای پرقدرت در سال 2023 حدود 50 میلیارد دلار ارزش داشت و انتظار میرود تا سال 2032 به بیش از 100 میلیارد دلار برسد. همانطور که انتظار میرود، بزرگترین شرکتهای فناوری، اصلیترین تامینکنندگان قطعات این کامپیوترها هستند. شرکت اچ پی (Hewlett Packard Enterprise) که در زمینه نرمافزار و رایانش ابری فعالیت میکند، یکی از بزرگترین تولیدکنندگان این کامپیوترها است. شرکت Dell Technologies هم در این زمینه فعال است و ابررایانههای قدرتمندی ساخته است.

شرکت انودیا (Nvidia) که در گذشته تنها در زمینه ساخت سختافزار به فعالیت اشتغال داشت، امروزه تراشههای جدیدی را تولید میکند که نقش تاثیرگذاری بر دنیای هوش مصنوعی دارند. شرکت مایکروسافت نیز با استفاده از سرویس ابری Azure، سختافزار و نرمافزار را با هم ترکیب کرده است تا کامپیوترهای پرقدرت بسازد.

مرز جدید

در حالی که محاسبات با عملکرد بالا در حال پیشرفت هستند، دانشمندان در حال ساخت نسل بعدی آنها تحت عنوان رایانش اگزاسکال (exascale computing) هستند. رایانش اگزاسکال میتواند یک کوادریلیون محاسبه در ثانیه انجام دهد و میتواند سیستمهایی را مدلسازی کند که محاسبات با عملکرد بالای فعلی قادر به انجام آن نیستند. در حقیقت، رایانش اگزاسکال زیرساخت نسل بعدی محاسبات با عملکرد بالا خواهد بود.

آنتونیو کورکلس میگوید: «نسل بعدی HPC از پردازندههای معمولی و گرافیکی و پردازندههای کوانتومی استفاده خواهد کرد تا مشکلات پیچیده را حل کند. این رویکرد باعث خواهد شد تا به توان محاسباتی قدرتمند و پیشرفتهای دست پیدا کنیم که پردازندههای کوانتومی بخش مهمی از آن خواهند بود».